ساختار شبکه MLP

جهت کسب اطلاع در مورد رودمپ عمومی هوش مصنوعی روی لینک رو به رو کلیک کنید.

شبکه عصبی پرسپترون چندلایه

فهرست محتوا:

- معرفی پرسپترون چندلایه

- توابع فعال ساز

- سیگموید

- RELU

- خطی

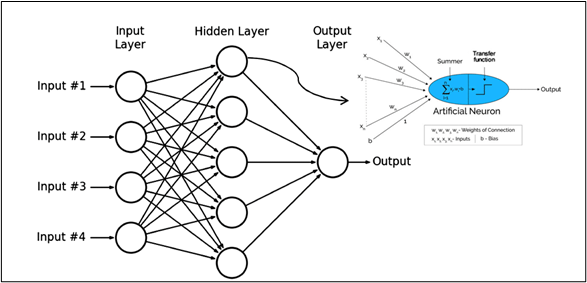

شبکه عصبی پرسپترون چندلایه یا MLP، از ساده ترین و قدیمی ترین شبکه های عصبی مصنوعی محسوب می شود. در شبکه عصبی پرسپترون چندلایه حداقل سه لایه از نودها که به آن نورون نیز گفته می شود، وجود دارد که عبارتند از: لایه ورودی، لایه نهان و لایه خروجی.

در هر لایه، نورون ها به این صورت کار می کنند که ابتدا مقادیر ورودی در وزن متناظر خود ضرب و با یک مقدار ثابت بایاس جمع می شوند. در نهایت، نتیجه این ضرب وارد یک تابع فعال ساز شده و خروجی آن به لایه بعدی منتقل می شود، این فرایند تا زمان رسیدن به آخرین لایه تکرار می شود.

به لایه هایی که بین لایه ورودی و لایه خروجی قرار می گیرند لایه نهان گفته می شود. تابع فعال ساز تصمیم می گیرد که هر نورون فعال باشد یا نباشد. قبل از بررسی توابع فعال ساز مدل MLP، به رسم ساختار مدل پرداخته می شود. این شبکه ها می توانند تعداد ورودی و لایه های پنهان و خروجی متفاوتی داشته باشند. برای آشنایی و درک بهتر، ساختار شبکه با ۴ ورودی در شکل زیر رسم شده است.

در شکل فوق، لایه اول مربوط به لایه های ورودی، لایه دوم مربوط به لایه های نهان و لایه سوم مربوط به لایه خروجی می باشد. جهت آشنایی با عملیاتی که در داخل نورون ها انجام می شود، شکل بازشده یک نورون عصبی نیز در شکل بالا نشان داده شده است.

توابع فعال سازی شبکه های عصبی پرسپترون چندلایه

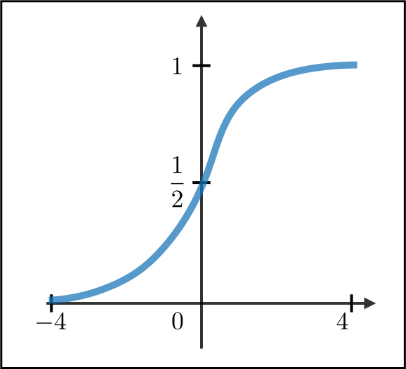

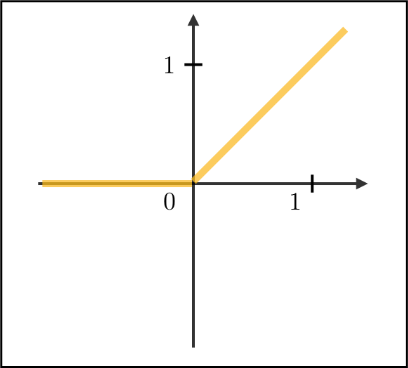

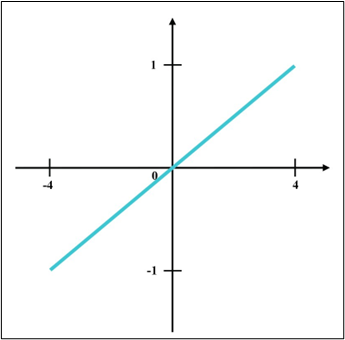

برخی از توابع فعال سازی که برای شبکه های عصبی پرسپترون چندلایه مورد استفاده قرار می گیرند توابع فعال سازی Sigmoid ،RELU و Linear هستند. رابطه شماره ۱ مربوط به تابع فعال سازی Sigmoid، رابطه شماره ۲ مربوط به تابع فعال سازی RELU و رابطه شماره ۳ مربوط به تابع فعال سازی Linear است.

رابطه شماره ۱

رابطه شماره ۲

رابطه شماره ۳

تابع Sigmoid مقادیر را در میان بازه [0،1] قرار می دهد. تابع فعال ساز RELU به این صورت عمل می کند که مقادیر منفی را صفر، مقادیر مثبت و مقادیر برابر با صفر را همان مقدار خودشان در نظر می گیرد. تابع فعال ساز خطی جمع وزن دار ورودی هر نود را عینا برمی گرداند و مقادیر را در بازه خاصی قرار نمی دهد. برای داده هایی با پیچیدگی بالا استفاده از این نوع تابع توصیه نمی شود زیرا نمی تواند پردازش چنین داده هایی را به درستی انجام دهد.

شکل مربوط به هریک از توابع فعال سازی نیز برای درک بهتر توابع رسم شده است. شکل شماره ۱ مربوط به تابع فعال ساز Sigmoid، شکل شماره ۲ مربوط به تابع فعال ساز RELU و شکل شماره ۳ مربوط به تابع فعال ساز خطی است.

شکل شماره ۱- نمودار تابع فعال سازی Sigmoid

شکل شماره ۲- نمودار تابع فعال سازی RELU

شکل شماره ۳- نمودار تابع فعال سازی Linear